OpenAI twierdzi, że jest niezadowolone ze sprzętu Nvidia do wnioskowania, teraz rozgląda się za AMD, Cerebras, Groq

OpenAI nie jest już zadowolone z chipów AI firmy Nvidia, szczególnie jeśli chodzi o szybkość odpowiedzi dla użytkowników. Firma zaczęła szukać innych opcji w zeszłym roku i obecnie prowadzi rozmowy z AMD, Cerebras, a wcześniej rozmawiała również z Groq, zanim to zostało przerwane.

Napięcie zaczęło narastać, gdy OpenAI zdało sobie sprawę, że chipy Nvidia nie są wystarczająco szybkie do konkretnych zadań, takich jak pisanie kodu i obsługa zadań między oprogramowaniem.

Według informacji z wewnętrznych źródeł, OpenAI chce, aby nowe chipy obsługiwały co najmniej 10% jego potrzeb inferencyjnych w przyszłości. To ta część, w której AI odpowiada użytkownikom, a nie ta, w której się uczy.

OpenAI potrzebuje szybszych chipów do kodowania i odpowiedzi użytkownikom

Większość obecnych zadań OpenAI nadal działa na Nvidia, ale za kulisami firma testuje chipy, które mogłyby przyspieszyć wszystko.

Obejmuje to chipy wyposażone w SRAM, co przyspiesza działanie poprzez umieszczenie pamięci bezpośrednio obok procesora. Nvidia i AMD nadal używają pamięci znajdującej się poza chipem, co spowalnia działanie.

Pracownicy OpenAI wskazywali na Codex, narzędzie do pisania kodu, jako miejsce, gdzie wolność działania była największym problemem. Niektórzy pracownicy obwiniali nawet słabą wydajność sprzętu Nvidia. Podczas konferencji prasowej 30 stycznia CEO OpenAI, Sam Altman, powiedział: "Klienci korzystający z naszych modeli kodowania będą przywiązywać dużą wagę do szybkości pracy nad kodem."

Sam dodał, że zwykli użytkownicy ChatGPT nie przywiązują tak dużej wagi do szybkości, ale dla programistów i firm każda sekunda ma znaczenie. Powiedział, że OpenAI właśnie podpisało umowę z Cerebras, aby przyspieszyć działanie.

Jednocześnie firmy takie jak Anthropic i Google osiągają lepsze wyniki, używając własnych chipów. TPU Google są zbudowane specjalnie do pracy wymaganej przez inferencję. To sprawiło, że są szybsze w odpowiadaniu, szczególnie w przypadku modeli takich jak Claude i Gemini.

Rozmowy OpenAI-Groq zostały przerwane po zawarciu umowy licencyjnej przez Nvidia

OpenAI prowadziło również rozmowy z Groq, innym startupem budującym szybkie chipy, ale te rozmowy nie zaszły daleko. Nvidia wkroczyła i podpisała umowę licencyjną o wartości 20 miliardów dolarów z Groq. To dało Nvidia dostęp do projektów Groq i zniszczyło plany OpenAI dotyczące współpracy z nimi.

Źródło zbliżone do sytuacji powiedziało, że chipy Groq zostały stworzone dokładnie pod to, czego potrzebowało OpenAI. Ale gdy Nvidia zabezpieczyła umowę, ta droga została zamknięta. Mimo że licencja nie była wyłączna, Groq skupia się teraz na oprogramowaniu chmurowym, a Nvidia przejęła niektórych projektantów chipów Groq.

Cerebras z kolei odmówiło, gdy Nvidia próbowała je kupić. Zamiast tego zawarli własną umowę z OpenAI. Groq również otrzymał oferty inwestycyjne wyceniające firmę na około 14 miliardów dolarów, ale teraz się to zmieniło, ponieważ jest powiązana z Nvidia.

OpenAI nie odeszło całkowicie od Nvidia. W publicznym oświadczeniu rzecznik powiedział: "Polegamy na Nvidia w zasilaniu ogromnej większości naszej floty inferencyjnej" i nazwał ich wydajność w przeliczeniu na dolara najlepszą na rynku. Nvidia również stwierdziła: "Klienci nadal wybierają Nvidia do inferencji, ponieważ zapewniamy najlepszą wydajność i całkowity koszt posiadania na dużą skalę."

Umowa inwestycyjna Nvidia o wartości 100 miliardów dolarów wciąż zawieszona w próżni

W zeszłym roku Nvidia oświadczyła, że planuje zainwestować do 100 miliardów dolarów w OpenAI. Te pieniądze miały pomóc OpenAI kupić bardziej zaawansowane chipy, a w zamian Nvidia miała otrzymać udział w firmie. Reuters poinformował, że umowa miała zostać zamknięta w ciągu kilku tygodni. Nadal tak się nie stało.

Podczas gdy ta umowa utknęła w martwym punkcie, OpenAI podpisało umowy z AMD i innymi w celu testowania chipów, które mogłyby konkurować bezpośrednio z Nvidia. Ale gdy OpenAI zmieniło swoje plany produktowe, zmienił się również rodzaj potrzebnego sprzętu. To jeszcze bardziej spowolniło rozmowy, powiedziała osoba zaznajomiona z sytuacją.

W sobotę CEO Nvidia, Jensen Huang, został zapytany o tarcia. Powiedział: "To nonsens" i upierał się, że Nvidia nadal planuje dużo zainwestować w OpenAI. Ale za kulisami jest jasne, że obie strony badają swoje opcje.

Jednocześnie Nvidia szukała nowych pomysłów na chipy. Skontaktowała się zarówno z Cerebras, jak i Groq, aby sprawdzić, czy byliby otwarci na zakup. Cerebras to odrzuciło i podwoiło zaangażowanie w umowę z OpenAI.

Obecnie OpenAI używa GPT4o do zasilania większości swoich usług. Ale patrząc na to, jak się sprawy mają, przynajmniej część tej pracy będzie działać na chipach AMD lub Cerebras w najbliższej przyszłości. Firma nie próbuje całkowicie porzucić Nvidia, ale jest jasne, że chce mieć większą kontrolę nad tym, jak szybko działają jej systemy.

Wyostrz swoją strategię dzięki mentorowi i codziennym pomysłom - 30 dni bezpłatnego dostępu do naszego programu tradingowego

Możesz także polubić

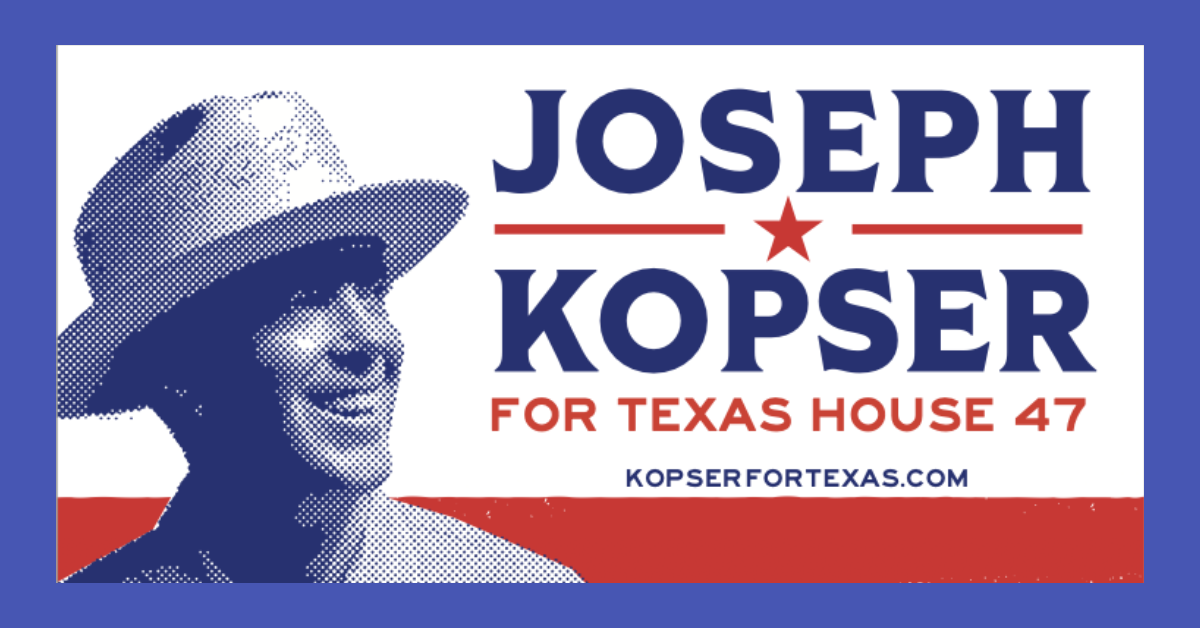

Kopser for Texas dociera do 18 tys. niezarejestrowanych wyborców w hrabstwie Travis

Nastroje wokół Bitcoina spadają do ekstremalnego strachu, spodziewane są dalsze straty